Защита сайт от ботов – неотъемлемая часть стратегии успешного присутствия в Интернете. Определить DDos-атаку или наплыв спам-ботов просто. На веб-сайте появляются подозрительные ссылки в комментариях, а также резкое увеличение недействительных контактов.

Отсутствие эффективных мер защиты снижает рейтинг в поисковиках, что сказывается на генерации лидов. Еще одно последствие – уязвимость ресурса. Недоверие у пользователей вызывают те ресурсы, где существуют угрозы взлома злоумышленниками и утечки персональных данных.

В статье рассмотрим примеры ботов, их особенности и методы, которые помогут укрепить безопасность.

Зачем нужны боты?

Использование ботов позволяет оптимизировать онлайн-присутствие бизнеса, которое достигается за счет следующих факторов:

- Имитация поведения пользователей. Они могут “просматривать” страницы, взаимодействовать с контентом и т.д. Этот позволяет накрутить поведенческие факторы и вывести ресурс в топ.

- Анализ пользовательского опыта. Изучают взаимодействие пользователей с ресурсом, формируя модель пользовательского опыта. Это позволяет выявить места, где посетители теряют интерес, и оптимизировать интерфейс для повышения их удовлетворенности.

- Тестирование функциональности. Боты проверяют безопасность платформы через тестирование функций. Таким образом, с их помощью можно выявляют уязвимые места и устранять потенциальные угрозы.

- Улучшение ранжирования в поисковиках. Поведенческие факторы – важным критерий для оценки релевантности и качества контента. Боты создают положительные поведенческие сигналы, улучшая видимость.

- Маркетинговые исследования конкурентов. Применяются для изучения конкурентов. Они отслеживают уровень активности, вносимые изменения. Полученная информация используется для разработки стратегии продвижения.

- Улучшение аналитики. Выполняют сбор объективных и структурированных сведений о поведении пользователей. Эти данные дают возможность принимать обоснованные стратегические решения.

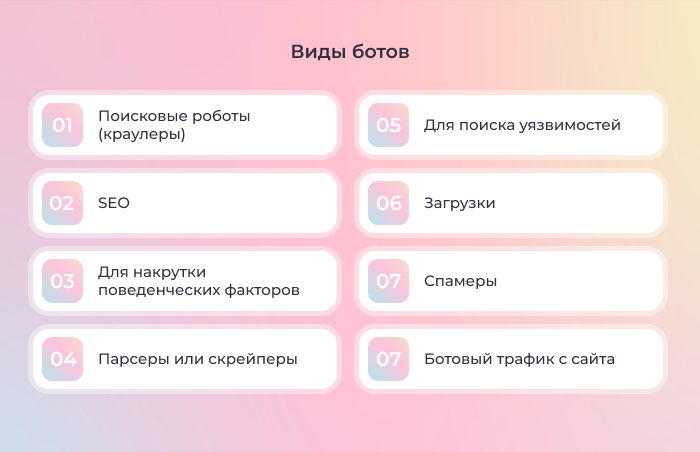

Виды ботов

- Поисковые роботы (краулеры). Это инструмент Google, Яндекс и других поисковых систем, который сканирует интернет в поиске новых страниц, облегчая индексацию контента. Эти роботы полезны для SEO-оптимизации.

- SEO. Помогают проанализировать конкурентов, получить информацию о своем рейтинге. Эта информация способствует оптимизации поисковой выдачи. Однако они могут вызвать нагрузку.

- Для накрутки поведенческих факторов. Искусственно повышают посещаемость. Достигается это через имитацию активности реальных пользователей, снижая показатель отказов. Также их можно использовать для смещения сайтов-конкурентов с топовых позиций.

- Парсеры или скрейперы. Собирают адреса, контактные данные со страниц. В некоторых случаях они могут воровать контент. Это приводит к снижению уникальности контента и ухудшению поисковой выдаче.

- Для поиска уязвимостей. Изучают сайт на наличие уязвимостей. Их опасность заключается в том, что они передают собранную информацию не только владельцам, но и третьим лицам.

- Загрузки. Занимаются скачиванием размещенных материалов с онлайн-серсвиса, которую используют как лид-магнит. В то же время возможно искажение данных об эффективности контента. Ложные сведения вводят в заблуждение владельца относительно интереса пользователей к контенту.

- Спамеры. Заполняют формы обратной связи, оставляют комментарии рекламного характера. Используются для фишинга. Их активность снижает репутацию ресурса.

- Ботовый трафик с сайта. Подражают поведению пользователя, кликая по рекламе, баннерам, ссылкам. Искажают данные показов, количества кликов. В итоге статистика высокая, но продажи низкие. Из-за повышенной активности клик-ботов можно получить бан, так как система расценит это как накрутку.

Способы защиты сайта от спама

Источники взаимодействия с клиентом подвергаются атакам. Повысить надежность системы возможно с помощью следующих инструментов:

- Антивирусное программное обеспечение. Установка антивируса на компьютер защищает устройство от вредоносных программ в режиме реального времени. Автоматическое обновление программы обеспечит защиту от всевозможных атак и предотвратит удаленный захват злоумышленниками.

- Регулярное обновление систем. Проверяйте наличие обновления для операционной системы, браузера. Разработчики выпускают доработки систем, чтобы исправить уязвимые места. Это действие позволяет защитить сайт от спама.

- Надежные пароли. Используйте сложные пароли, которые содержат цифры, заглавные и строчные буквы, символы. Пароль должны быть уникальными для разных учетных записей.

- Проверенные источники. Переходите по проверенным ссылкам. Это правило касается и электронной почты. Открывайте сообщения от источников, которым вы доверяете. Внимательно относитесь к загрузке материалов.

- Фильтры, плагины. Защитить сайт от ботов поможет установка плагинов, которые блокируют вредоносные атаки, фильтруют нежелательный трафик.

- Менеджер ботов. Применение этого инструмента позволяет останавливать посещение ресурса вредоносными ботами, разрешая доступ только тем программам, которые выполняют полезные функции.

- Ограничение скорости. Предотвратить повышенную активность с одного адреса поможет ограничения скорости для IP-адресов.

- CAPTCHA. Еще один инструмент – размещение контрольных изображений CAPTCHA для отличия роботов от людей.

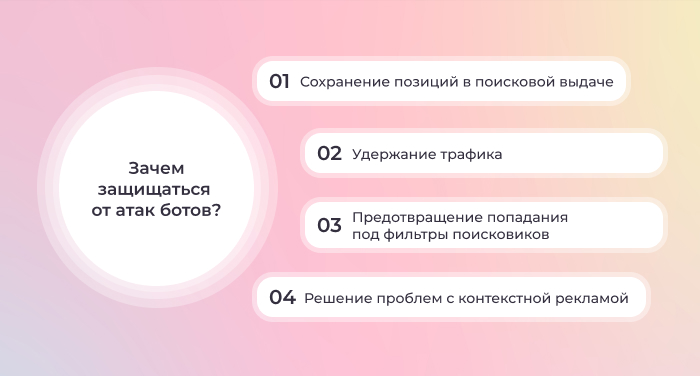

Зачем защищаться от атак ботов?

- Сохранение позиций в поисковой выдаче. Защита сайтов, выполненных на тильде или других конструкторах, от атак ботов помогает предотвратить смещение ресурса с топовых позиций. Восстановить положение невозможно даже при наличии качественного контента. Единственное возможное решение – смена URL страницы.

- Удержание трафика. Атаки вызывают медленное, но стабильное падение поискового трафика. Этот эффект прежде всего затрагивает Яндекс.

- Предотвращение попадания под фильтры поисковиков. Нетипично высокую активность поисковые системы классифицируют как искусственный трафик. Это может привести к бану и снижения видимости ресурса.

-

- Решение проблем с контекстной рекламой. Атаки вызывают трудности с контекстной рекламой. Например, случайные клики на рекламные блоки искажают показатели, снижая эффективность рекламной кампании.

Оцените статью